Woensdag introduceerde Google PaLM2, een familie van basistaalmodellen die vergelijkbaar is met het GPT-4-model van OpenAI. Tijdens het Google I/O-evenement in Mountain View, Californië, onthulde Google dat het al PaLM 2 gebruikt om 25 producten aan te drijven, waaronder de conversationele AI-assistent Bard.

Als een familie van grote taalmodellen (LLM’s) is PaLM 2 getraind op een enorme hoeveelheid gegevens en voert het de voorspelling van het volgende woord uit, wat de meest waarschijnlijke tekst oplevert na snelle invoer door mensen. PaLM staat voor Pathways Language Model enarcadeis een machine learning-technologie gemaakt door Google. PaLM 2 volgt een bestand De originele PALMAangekondigd door Google in april 2022.

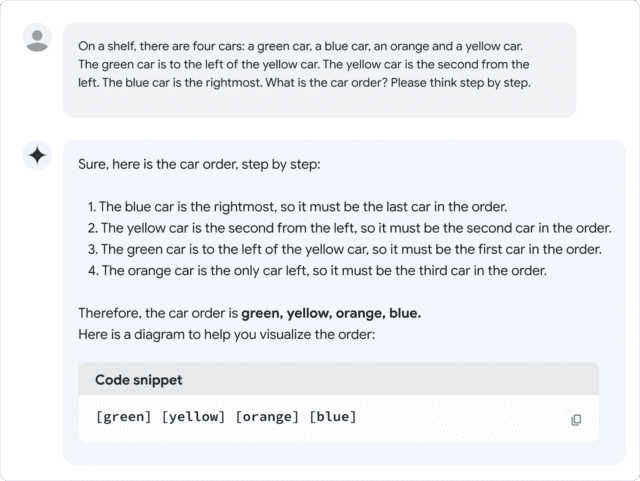

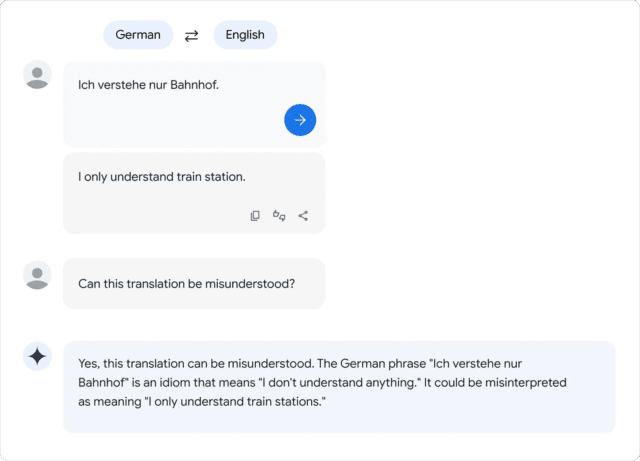

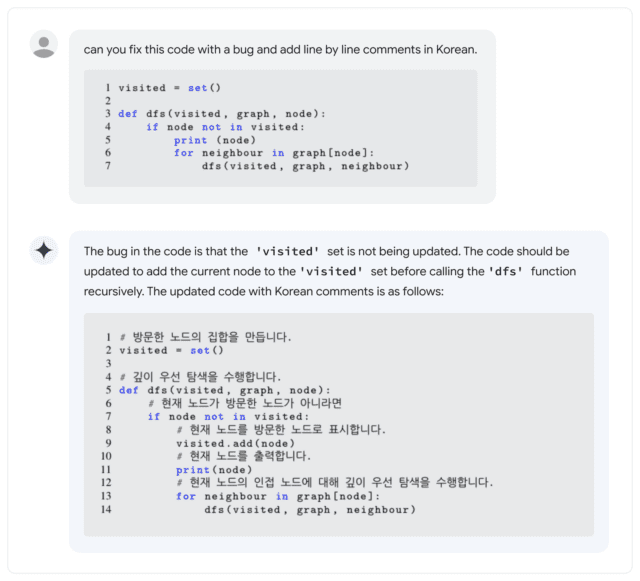

Volgens Google ondersteunt PaLM 2 meer dan 100 talen en kan het “logisch redeneren”, code genereren en meertalige vertalingen uitvoeren. Tijdens zijn keynote op Google I/O 2023 zei Google-CEO Sundar Pichai dat de PaLM 2 in vier formaten verkrijgbaar is: Gecko, Otter, Bison en Unicorn. Gecko is de kleinste en kan op een mobiel apparaat worden gespeeld. Afgezien van de Bard, zit PaLM 2 achter AI-functies in documenten, spreadsheets en presentaties.

Dit is allemaal goed en wel, maar hoe verhoudt PaLM 2 zich tot GPT-4? In de PaLM technisch rapport 2PaLM2 Het lijkt Om GPT-4 te verslaan in sommige wiskundige, vertaal- en inferentietaken. Maar de realiteit komt mogelijk niet overeen met de Google-normen. In een snelle evaluatie van de PaLM 2-versie van de Bard door Ethan Mollick, een Wharton-professor die vaak over kunstmatige intelligentie schrijft, ontdekte Mollick dat PaLM 2 slechter presteert dan GPT-4 en Bing op verschillende informele taaltesten, wat Scharnier in de Twitter-thread.

Tot voor kort was de PaLM-familie van taalmodellen een intern product van Google Research zonder blootstelling aan consumenten, maar Google is begonnen Geef beperkte toegang tot de API in maart. De eerste PaLM viel echter op door zijn enorme omvang: 540 miljard parameters. Parameters zijn numerieke variabelen die dienen als de verworven “kennis” van het model, waardoor het voorspellingen kan doen en een script kan genereren op basis van de input die het ontvangt.

Meer parameters betekent grofweg meer complexiteit, maar er is geen garantie dat ze efficiënt worden gebruikt. Ter vergelijking: OpenAI’s GPT-3 (vanaf 2020) heeft 175 miljard parameters. OpenAI heeft nooit het aantal parameters in GPT-4 bekendgemaakt.

En dit leidt tot de grote vraag: hoe “groot” is PaLM 2 in termen van aantal parameters? Google niet zeggenwat sommigen frustreerde Industrie-experts die vaak campagne voeren voor meer transparantie over wat AI-modellen drijft.

Dit is niet de enige PaLM 2-functie die Google niet over het hoofd heeft gezien. bedrijf Hij zegt zegt dat PaLM 2 is getraind op “een verscheidenheid aan bronnen: webdocumenten, boeken, code, wiskunde en gespreksgegevens”, maar gaat niet in detail in op wat die gegevens precies zijn.

Net als bij andere datasets van grote taalmodellen, bevat de PaLM 2-dataset waarschijnlijk een grote verscheidenheid aan Auteursrechtelijk beschermd materiaal Gebruikt zonder toestemming en materialen die schadelijk kunnen zijn afschrapen internetten. Trainingsgegevens hebben een kritische invloed op de output van elk AI-model, dus sommige experts pleiten voor het gebruik van datasets openen Het kan kansen bieden voor wetenschappelijke reproductie en ethische toetsing.

“Nu LLM producten is (en niet alleen onderzoek), bevinden we ons op een omslagpunt: bedrijven met winstoogmerk zullen *specifiek* minder transparant worden over welke componenten er het meest toe doen,” tjilpen Jesse Dodge, onderzoeker bij Allen Instituut voor Kunstmatige Intelligentie. “Alleen als de open source-gemeenschap zich samen kan organiseren, kunnen we het bijbenen!”

Tot nu toe heeft de kritiek op het verbergen van de geheime saus Google er niet van weerhouden om AI-modellen op grote schaal in te zetten, ondanks de neiging van alle LLM’s om dingen uit het niets te verzinnen. Tijdens de Google I/O-conferentie demonstreerden vertegenwoordigers van het bedrijf AI-functies in verschillende van zijn vlaggenschipproducten, wat betekent dat een brede dwarsdoorsnede van het publiek binnenkort met AI-problemen te maken zou kunnen krijgen.

En in termen van LLM’s is PaLM 2 nog lang niet het einde van het verhaal: tijdens de I/O-keynote zei Pichai dat een nieuw multimedia-AI-model genaamd “Gemini” momenteel in opleiding was. Terwijl de race om AI-dominantie voortduurt, worden Google-gebruikers in de Verenigde Staten en 180 andere landen (de onbekende behalve Canada en het vasteland van Europa) kan Probeer PaLM 2 zelf Als onderdeel van Google Bard, de experimentele AI-assistent.

“Hipster-Friendly Explorer. Award-Winning Coffee Fanatic. Analyst. Problem Solver. Troublemaker.”

More Stories

Steam, Epic en GMG annuleren pre-orders voor Ghost of Tsuima PC in niet-PSN-landen

Google en Apple zijn nog steeds in gesprek om Gemini-functies in iPhone AI te gebruiken

Sam Altman plaagt de OpenAI-demo van maandag die ‘voelt als magie’