Een van de belangrijkste verdedigingen die worden gebruikt door degenen die uitblinken in kunstgeneratoren met AI, is dat hoewel de modellen zijn getraind op bestaande afbeeldingen, alles wat ze maken nieuw is. Missionarissen voor kunstmatige intelligentie vaak Vergelijk deze systemen met echte artiesten. De makers laten zich inspireren door al degenen die hen voorgingen, dus waarom zou je de AI niet vergelijkbaar maken met het vorige werk?

Het nieuwe onderzoek zou dat argument kunnen dwarsbomen, en het zou zelfs een belangrijk knelpunt kunnen worden Verschillende lopende rechtszaken met betrekking tot door AI gegenereerde inhoud en auteursrecht. Onderzoekers in zowel de industrie als de academische wereld hebben ontdekt dat de meest populaire en opkomende AI-beeldgeneratoren afbeeldingen kunnen “opslaan” van de gegevens waarop ze zijn getraind. In plaats van iets geheel nieuws te creëren, laten sommige prompts de AI gewoon een afbeelding reproduceren. Sommige van deze opnieuw gemaakte afbeeldingen kunnen auteursrechtelijk beschermd zijn. Maar erger nog, moderne AI-generatieve modellen hebben de mogelijkheid om gevoelige informatie die is verzameld voor gebruik in een AI-trainingsset op te slaan en te reproduceren.

aan het studeren Uitgevoerd door technologieonderzoekers – om precies te zijn De Google en DeepMind – en aan universiteiten als Berkeley en Princeton. Dezelfde bemanning werkte door vorige studie die een soortgelijk probleem identificeerde met AI-taalmodellen, met name GPT2, Inleiding tot OpenAI-modellen ChatGPT is erg populair. Toen ze de band weer bij elkaar brachten, ontdekten onderzoekers onder leiding van Google Brain-onderzoeker Nicholas Carlini dat zowel Google’s Imagen als de populaire open source Stable Diffusion in staat waren om de afbeeldingen te reproduceren, waarvan sommige duidelijke copyright- of licentie-implicaties voor de afbeeldingen hadden.

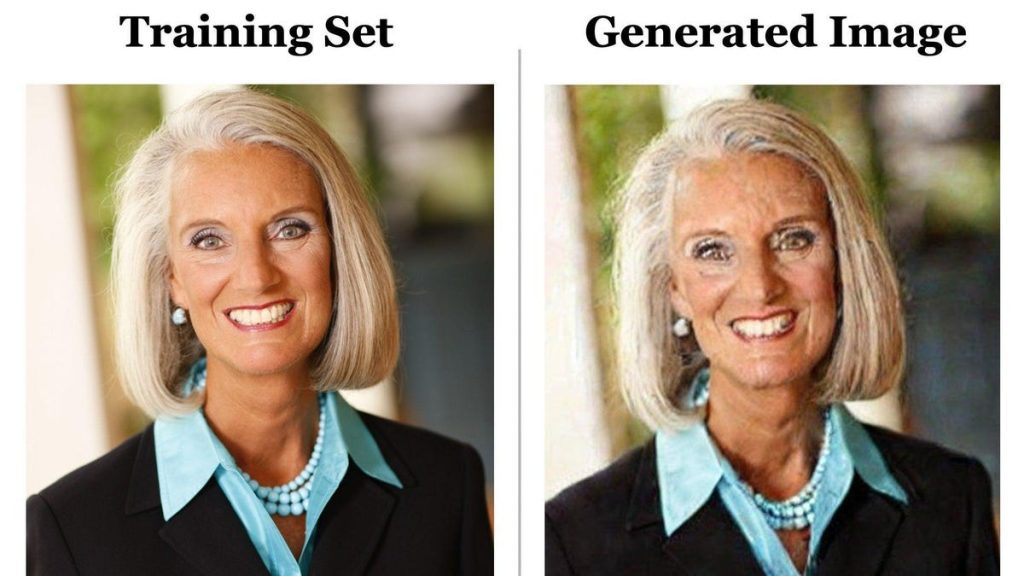

De eerste afbeelding in die tweet is gemaakt met behulp van het bijschrift in de Stable Diffusion-dataset, de multi-terabyte gefragmenteerde beelddatabase die bekend staat als LAION. Het team voerde het bijschrift in de “Stable Diffusion”-prompt in en ze kwamen eruit met precies hetzelfde beeld, hoewel enigszins vervormd door digitale ruis. Het vinden van deze dubbele foto’s was relatief eenvoudig. Het team voerde dezelfde prompt verschillende keren uit en nadat ze hetzelfde resulterende beeld hadden verkregen, controleerden de onderzoekers handmatig of het beeld aanwezig was in de trainingsset.

G/O Media kan een commissie verdienen

Twee van de onderzoekers op de krant Eric Wallace, een promovendus aan UC Berkeley, en Vikash Siwag, een promovendus aan de Princeton University, vertelden Gizmodo in een Zoom-interview dat beeldreplicatie zeldzaam is. Hun team probeerde ongeveer 300.000 verschillende bijschriften en vond een memorisatiepercentage van slechts 0,3%. Gedupliceerde afbeeldingen waren veel zeldzamer voor modellen zoals Stable Diffusion die afbeeldingen ontdubbelden in hun trainingsset, hoewel uiteindelijk alle diffusiemodellen in meer of mindere mate hetzelfde probleem zullen hebben. De onderzoekers ontdekten dat Imagen perfect in staat was om afbeeldingen te onthouden die maar één keer in de dataset voorkomen.

“Het voorbehoud hier is dat het model verondersteld wordt te generaliseren, en dat het nieuwe beelden moet genereren in plaats van een kopie uit het geheugen uit te spuwen,” zei Sehwag.

Hun onderzoek toont aan dat naarmate AI-systemen groter en complexer worden, de kans groter wordt dat AI gerepliceerd materiaal produceert. Een kleiner model als Stable Diffusion heeft simpelweg niet dezelfde hoeveelheid opslagruimte om de meeste trainingsgegevens op te slaan. Dat Er kan de komende jaren veel veranderen.

“Misschien volgend jaar, welk nieuw model er ook uitkomt dat een stuk groter en veel krachtiger is, zullen dat soort instandhoudingsrisico’s waarschijnlijk veel groter zijn dan nu,” zei Wallace.

Via een complex proces waarbij de trainingsgegevens met ruis worden vernietigd voordat dezelfde vervorming wordt verwijderd, genereren op diffusie gebaseerde machine learning-modellen gegevens – in dit geval afbeeldingen – vergelijkbaar met wat erop is getraind. Verspreidingsmodellen waren een evolutie van generatieve vijandige netwerken of GAN-gebaseerd machinaal leren.

De onderzoekers ontdekten dat op GAN gebaseerde modellen niet hetzelfde probleem hebben bij het opslaan van afbeeldingen, maar het is onwaarschijnlijk dat grote bedrijven verder zullen gaan dan verspreiding, tenzij er een meer geavanceerd machine learning-model opduikt dat realistischere afbeeldingen van hogere kwaliteit produceert.

Florian Trammer, een professor computerwetenschappen aan de ETH Zürich die betrokken was bij het onderzoek, merkte op hoeveel AI-bedrijven gebruikers adviseren, zowel in gratis als betaalde versies, om een licentie te verlenen om door AI gegenereerde inhoud te delen of er zelfs geld mee te verdienen. De AI-bedrijven behouden zich zelf ook enkele rechten voor op deze beelden. Dit kan een probleem zijn als de AI een afbeelding maakt die exact overeenkomt met het bestaande copyright.

Met een opslagpercentage van slechts 0,3% kunnen AI-ontwikkelaars dit onderzoek bekijken en vaststellen dat er niet al te veel risico is. Bedrijven kunnen werken aan het verwijderen van afbeeldingsduplicaten in trainingsgegevens, waardoor de kans kleiner wordt dat ze worden opgeslagen. Verdorie, ze zouden zelfs AI-systemen kunnen ontwikkelen die kunnen detecteren of een afbeelding een directe duplicaat is van een afbeelding in de trainingsgegevens en deze markeren voor verwijdering. Het verbergt echter het volledige privacyrisico van generatieve AI. Carlini en Trammer hielpen ook mee Nog een recent artikel Waarop ik betoogde dat zelfs pogingen om de gegevens te filteren nog steeds niet voorkwamen dat de trainingsgegevens door het model lekten.

En natuurlijk is het risico groot dat er afbeeldingen op de schermen van gebruikers verschijnen die niemand wil reproduceren. Wallace vroeg of de onderzoeker bijvoorbeeld een volledige set synthetische medische gegevens wilde maken voor röntgenfoto’s van mensen. Wat zou er moeten gebeuren als kunstmatige intelligentie op basis van diffusie wordt gered En de feitelijke medische gegevens van een persoon dupliceren?

“Het is zeer zeldzaam, dus je merkt het misschien eerst niet, en dan kun je die dataset daadwerkelijk op internet publiceren”, zei de UC Berkeley-student. “Het doel van dit werk is om die potentiële soorten fouten die mensen kunnen maken een beetje voor te zijn.”

“Communicator. Muziekliefhebber. Gecertificeerde bacon-pionier. Reisadvocaat. Subtiel charmante social media-fanaat.”

More Stories

'1000 Pound Sisters' Tammy Slaton toont haar geweldige reis naar gewichtsverlies

Nick Carter en Aaron Carter worden onderzocht in identiteitsdocuseserie 'Fallen Idols'

“Crackhead Barney” zegt dat ze verminkt is door Alec Baldwin